3 entrenamientos para reducir sesgos al evaluar desempeño

¿Cansado de que dos jefes miren al mismo equipo y saquen veredictos opuestos?

Cuando no hay estándar ni evidencia del ciclo, el cerebro rellena los vacíos con atajos… y la calibración se vuelve una pelea.

Aquí encontrarás 3 entrenamientos concretos para alinear criterios, registrar conductas y bajar sesgos antes del cierre. Menos desgaste, más justicia defendible.

Por qué aparecen sesgos incluso en líderes competentes

La evaluación del desempeño mezcla tres cosas explosivas:

→ Juicio humano.

→ Memoria selectiva.

→ Consecuencias reales (aumentos, promociones, reputación).

Eso abre la puerta a errores típicos de evaluación (sesgos o “errores del evaluador”):

→ Halo: una fortaleza tapa todo lo demás.

→ Recencia: pesa demasiado lo último que pasó.

→ Primacía: pesa demasiado lo primero que pasó.

→ Leniencia/severidad: algunos ponen siempre alto o siempre bajo.

→ Tendencia central: casi todos quedan “promedio”.

→ Similitud/afinidad: “me recuerda a mí”, entonces lo veo mejor.

¿La trampa? Muchos líderes creen que con “ser justos” basta.

Pero la justicia no es una intención. Es un diseño.

Ahí entran RET, FOR y BO: tres entrenamientos complementarios que atacan causas distintas del sesgo.

El gran beneficio oculto: menos calibración (y menos desgaste)

Cuando entrenas a evaluadores, no solo “sube la calidad” por un ideal ético. También baja el costo operativo de tu proceso:

→ Menos tiempo discutiendo notas sin evidencia.

→ Menos retrabajo para RR. HH. corrigiendo incoherencias.

→ Menos reclamos de “esto es injusto”.

→ Más confianza en Nine Box y decisiones de talento.

Y esto no es solo sentido común: décadas de investigación sobre entrenamiento de evaluadores muestran mejoras en precisión, consistencia y criterios compartidos, especialmente con Frame of Reference (FOR).

Los 3 entrenamientos para disminuir sesgos

1) RET (Rater Error Training): conciencia de sesgos

Qué es (en simple): RET enseña a reconocer los errores típicos del evaluador (halo, leniencia, recencia, etc.) y a evitar “trampas mentales” comunes.

Objetivo real: hacer consciente lo que antes pasaba en piloto automático.

Cómo se entrena normalmente:

→ Explicación clara de sesgos y por qué ocurren.

→ Videos o casos cortos donde el sesgo se ve “en vivo”.

→ Discusión guiada: “¿Dónde me pasa esto a mí?”.

→ Micro-técnicas de corrección (checklist, pausas, contraste con evidencia).

Lo que RET hace bien: sube conocimiento sobre sesgos y hace que el líder “se mire” antes de evaluar.

Su límite (importante): RET puede mejorar conciencia… pero no garantiza que el líder aplique estándares correctos ni que observe mejor durante el año. Por eso suele considerarse más superficial que FOR y BO si tu objetivo final es precisión sostenida.

Cuándo RET es ideal:

→ Cuando estás partiendo y necesitas un “idioma común” sobre errores.

→ Cuando detectas sesgos evidentes (halo/leniencia) y quieres un shock de realidad rápido.

→ Cuando vas a lanzar 360° y necesitas higiene mínima antes de abrir la puerta a muchos evaluadores.

2) FOR (Frame of Reference Training): un estándar compartido

Qué es (en simple): FOR crea un marco común para que distintos evaluadores entiendan lo mismo por “buen desempeño” y califiquen con criterios comparables.

Objetivo real: Que dos líderes vean la misma conducta… y la ubiquen en el mismo nivel de desempeño (o muy cerca).

Por qué suele ser el más efectivo: La evidencia acumulada (incluyendo meta-análisis) muestra que FOR es un método efectivo para mejorar la precisión de las evaluaciones.

Cómo se ve un FOR bien hecho (paso a paso):

Paso 1: Definir “qué significa” cada nivel

No basta con decir “cumple / excede”. Hay que bajar a conducta observable.

→ Qué hace alguien “sobresaliente” en esta competencia o meta.

→ Qué hace alguien “esperado”.

→ Qué hace alguien “bajo lo esperado”.

Paso 2: Practicar con casos (calificar, comparar, ajustar)

Aquí ocurre la magia:

→ Todos califican el mismo caso.

→ Se comparan las notas.

→ Se discute evidencia conductual, no opiniones.

→ Se corrige el estándar, juntos.

Paso 3: Feedback inmediato sobre el criterio

El líder no solo “aprende la teoría”. Aprende calibrando su criterio con el estándar.

Resultado típico cuando FOR se instala de verdad:

→ Baja la variabilidad absurda entre líderes.

→ Sube la comparabilidad entre áreas.

→ La calibración formal se vuelve más corta y menos emocional.

Cuándo FOR es ideal:

→ Cuando tu problema es incoherencia: “cada jefe evalúa a su pinta”.

→ Cuando tu Nine Box pierde credibilidad por diferencias entre evaluadores.

→ Cuando RR. HH. termina “arbitrando” más de lo que gestiona.

3) BO (Behavioral Observation Training): observar y registrar mejor

Qué es (en simple): BO entrena la capacidad de observar desempeño y registrarlo durante el ciclo para no depender de la memoria al final.

Objetivo real: Llegar a la evaluación con evidencia fresca y concreta, no con “sensaciones”.

Qué sesgos ataca con fuerza:

→ Errores de memoria (recencia/primacía).

→ Distorsiones por falta de datos (“no me acuerdo bien, pero…”).

→ Sesgos de contexto (un conflicto reciente contamina todo).

Cómo se entrena normalmente:

→ Técnicas para registrar incidentes críticos (positivos y negativos).

→ Cómo tomar notas breves, útiles y no invasivas.

→ Cómo separar conducta de interpretación.

→ Cómo usar bitácoras/diarios de desempeño sin burocracia.

Evidencia y lógica detrás: la investigación sobre entrenamiento de evaluadores, incluida la clasificación clásica de métodos (RET, FOR, BO, etc.), muestra que BO puede mejorar precisión observacional, porque fortalece la base de información con la que se evalúa.

Cuándo BO es ideal:

→ Cuando los líderes evalúan “de memoria” y eso genera peleas en calibración.

→ Cuando el feedback llega tarde, mal, o solo cuando hay problemas.

→ Cuando quieres pasar de evaluación anual a seguimiento continuo.

Comparación clara de RET vs FOR vs BO

Nivel de profundidad

→ RET: superficial; crea conciencia, pero no asegura cambio de hábito.

→ FOR: profundo; enseña a aplicar estándares comunes y mejora consistencia.

→ BO: muy profundo; mejora la observación y la calidad de evidencia en el tiempo.

Errores que busca minimizar

→ RET: errores generales (halo, recencia, contraste, similitud, etc.).

→ FOR: errores de interpretación y consistencia entre evaluadores.

→ BO: errores de memoria y sesgos por falta de datos objetivos.

Estrategia utilizada

→ RET: explicar sesgos, mostrar ejemplos, discutir correcciones.

→ FOR: definir estándares + ejercicios de evaluación comparativa.

→ BO: enseñar a observar, registrar y usar evidencia conductual.

Impacto esperado en precisión

→ RET: aumenta conciencia, no siempre precisión.

→ FOR: aumenta precisión al alinear criterios de evaluación.

→ BO: aumenta precisión al reducir distorsiones de memoria y contexto.

¿Cuál deberías aplicar primero? (guía rápida por síntomas)

Si hoy tu proceso se siente así:

“La gente no entiende sus errores”

→ Empieza con RET.

→ Objetivo: higiene mínima y vocabulario común.

“Cada jefe evalúa distinto”

→ Prioriza FOR.

→ Objetivo: un estándar compartido que haga comparables las notas.

“En calibración todos discuten porque no hay evidencia”

→ Implementa BO (y ojalá combinado con FOR).

→ Objetivo: dejar de evaluar desde memoria.

En la práctica, el combo más fuerte suele ser:

→ RET como base rápida (conciencia).

→ FOR como columna vertebral (criterio común).

→ BO como músculo diario (evidencia real).

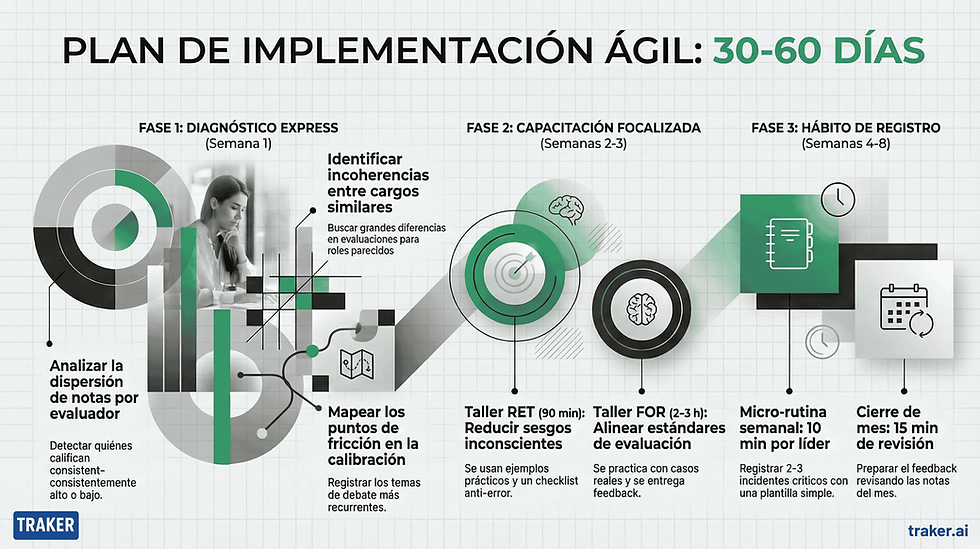

Plan de implementación (30–60 días) sin burocracia

Semana 1: Diagnóstico express (sin encuestas eternas)

→ Revisa dispersión de notas por evaluador (¿quién pone siempre alto?).

→ Detecta áreas con incoherencia (misma familia de cargos, notas muy distintas).

→ Identifica “momentos de pelea” en calibración (qué temas se repiten).

Semanas 2–3: RET + FOR (taller corto, alto impacto)

→ RET en 60–90 minutos: sesgos + ejemplos + checklist anti-error.

→ FOR en 2–3 horas: estándares + casos + práctica + feedback.

Semanas 4–8: BO como hábito (micro-rutina semanal)

→ 10 minutos a la semana por líder para registrar 2–3 incidentes críticos.

→ Una plantilla simple: conducta, contexto, impacto, evidencia.

→ Un “cierre de mes”: 15 minutos para revisar notas y preparar feedback.

Cómo medir si de verdad bajaron los sesgos

Si no lo mides, solo lo “sientes”. Y esto se presta para autoengaño.

Métricas prácticas:

→ Consistencia entre evaluadores (¿se acercan más las notas para casos similares?).

→ Distribución por líder (¿sigue existiendo el que pone todo 5?).

→ Cantidad de ajustes en calibración (¿se redujo el retrabajo?).

→ Calidad de evidencia (¿aparecen conductas observables, no adjetivos?).

→ Percepción de justicia (una pregunta corta post-ciclo puede bastar).

Tecnología como acelerador: menos fricción, más evidencia

Los entrenamientos son el “cambio de criterio”. Pero el día a día necesita soporte.

Cuando una plataforma hace visibles los datos, pasan dos cosas:

→ El líder deja de improvisar.

→ RR. HH. deja de perseguir planillas.

Por ejemplo, un enfoque moderno integra:

→ Calibración asistida para corregir sesgos y nivelar criterios entre evaluadores.

→ Seguimiento continuo que detecta estancamientos y activa alertas antes de que sea tarde.

→ Planes de desarrollo accionables, sugeridos según brechas detectadas (no PDFs olvidados).

La idea no es “reemplazar” el juicio humano. Es bajarle el ego y subirle la evidencia.

Y ahí, curiosamente, los entrenamientos despegan: porque la conducta registrada (BO) y el estándar compartido (FOR) quedan anclados en un sistema, no en la memoria del líder.

Preguntas frecuentes (FAQ)

¿Cuánto dura cada entrenamiento?

→ RET: 60–90 minutos si lo haces práctico.

→ FOR: 2–4 horas (depende de cuántas dimensiones uses).

→ BO: 60–120 minutos + rutina semanal mínima.

¿Se pueden hacer online?

→ Sí, pero con condición: debe haber práctica con casos y feedback (sobre todo en FOR).

¿Sirve esto en evaluaciones 360°?

→ Sirve mucho, porque multiplicas evaluadores y con eso multiplicas variabilidad.

→ FOR ayuda a que el “4” signifique algo parecido entre personas.

¿Qué pasa si mis competencias o criterios están mal definidos?

→ FOR te lo va a revelar rápido (y eso es bueno).

→ Si tu estándar es confuso, el entrenamiento lo expone y te obliga a mejorarlo.

¿Cada cuánto hay que repetir?

→ RET: refresco anual corto.

→ FOR: refresco cada ciclo + microcasos.

→ BO: se sostiene con hábito y seguimiento, no con “un taller al año”.

¿Esto reemplaza la calibración?

→ No. La vuelve más corta, más objetiva y menos desgastante.

→ Calibración sin entrenamiento es apagar incendios; con entrenamiento es mantención preventiva.

La evaluación justa no se promete… se entrena

Si hoy tu calibración se siente pesada, eterna, política, y a ratos injusta, no te falta “buena intención”.

Te falta una estructura que:

→ haga conscientes los sesgos (RET).

→ alinee criterios (FOR).

→ y convierta memoria en evidencia (BO).

Aplica estos tres entrenamientos como estrategias complementarias y vas a notar el cambio donde más importa:

→ conversaciones mejores.

→ decisiones más defendibles.

→ menos fricción entre líderes.

→ y una cultura donde el desempeño se gestiona, no solo se califica.

Si quieres acelerar esto con soporte tecnológico (calibración asistida, seguimiento y planes accionables), puedes revisar nuestra web TRAKER.

Agenda una demo y descubre cómo transformar la gestión del talento en tu organización con ayuda de la inteligencia artificial.